ในช่วงทศวรรษที่ผ่านมา วงการปัญญาประดิษฐ์ (AI) ได้พัฒนาก้าวกระโดดอย่างที่ไม่เคยมีมาก่อน โดยมีงานวิจัยสำคัญที่เป็นหมุดหมายแห่งการเปลี่ยนแปลงหลายชิ้น บทความนี้จะพาท่านไปสำรวจงานวิจัยที่มีอิทธิพลต่อการพัฒนา AI จนถึงปัจจุบัน

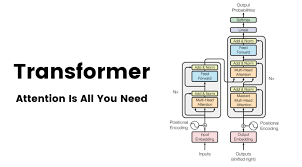

1. Transformer Architecture (2017)

“Attention Is All You Need”

งานวิจัยโดยทีม Google Research และ Google Brain ที่นำเสนอสถาปัตยกรรม Transformer ซึ่งปฏิวัติวงการประมวลผลภาษาธรรมชาติ (NLP)

ความสำคัญ:

- แนะนำกลไก Self-attention ที่ช่วยให้โมเดลเข้าใจความสัมพันธ์ระหว่างคำในประโยคได้ดีขึ้น

- ลดข้อจำกัดของ RNN และ LSTM ในการประมวลผลประโยคยาวๆ

- เป็นรากฐานของโมเดลภาษาขนาดใหญ่ (Large Language Models) ในปัจจุบัน

2. BERT (2018)

“Bidirectional Encoder Representations from Transformers”

งานวิจัยจาก Google AI ที่นำเสนอโมเดลภาษาที่เข้าใจบริบทแบบสองทิศทาง

ความสำคัญ:

- สร้างความเข้าใจภาษาที่ลึกซึ้งขึ้นผ่านการเรียนรู้แบบ bidirectional

- แนะนำวิธีการ pre-training ที่มีประสิทธิภาพ

- กลายเป็นมาตรฐานใหม่สำหรับงาน NLP หลากหลายประเภท

3. GPT (Generative Pre-trained Transformer)

จาก GPT-1 ถึง GPT-3 และต่อมา

งานวิจัยจาก OpenAI ที่พัฒนาโมเดลภาษาขนาดใหญ่

ความสำคัญ:

- แสดงให้เห็นว่าการเพิ่มขนาดโมเดลและข้อมูลฝึกฝนสามารถปรับปรุงความสามารถได้อย่างมีนัยสำคัญ

- นำเสนอแนวคิด few-shot learning ผ่านการใช้ prompts

- เปิดมุมมองใหม่เกี่ยวกับความสามารถของ AI ในการเข้าใจและสร้างเนื้อหา

4. Deep Learning Revolution

AlexNet (2012)

งานวิจัยที่ชนะการแข่งขัน ImageNet และจุดประกายการปฏิวัติ Deep Learning

ความสำคัญ:

- พิสูจน์ประสิทธิภาพของ Deep Neural Networks ในงานคอมพิวเตอร์วิชัน

- แนะนำเทคนิคสำคัญหลายอย่าง เช่น ReLU และ Dropout

- กระตุ้นการวิจัยด้าน deep learning อย่างกว้างขวาง

5. ResNet (2015)

“Deep Residual Learning for Image Recognition”

งานวิจัยจาก Microsoft Research ที่แก้ปัญหาการฝึกฝนโครงข่ายลึก

ความสำคัญ:

- แนะนำ residual connections ที่ช่วยแก้ปัญหา vanishing gradients

- ทำให้สามารถสร้างโครงข่ายที่ลึกขึ้นได้อย่างมีประสิทธิภาพ

- กลายเป็นสถาปัตยกรรมพื้นฐานสำหรับงานคอมพิวเตอร์วิชันจำนวนมาก

6. GANs (2014)

“Generative Adversarial Networks”

งานวิจัยที่นำเสนอแนวคิดการเรียนรู้แบบปฏิปักษ์

ความสำคัญ:

- สร้างวิธีการใหม่ในการสร้างข้อมูลสังเคราะห์ที่สมจริง

- เปิดทางสู่การพัฒนาเทคโนโลยี deep fake และการสร้างภาพ

- นำไปสู่การพัฒนาโมเดลสร้างภาพรุ่นต่อมา เช่น DALL-E และ Stable Diffusion

7. นวัตกรรมการฝึกฝนและการปรับปรุงประสิทธิภาพ

7.1 Batch Normalization (2015)

- ช่วยเร่งการฝึกฝนโมเดลให้เร็วขึ้น

- ลดปัญหา internal covariate shift

- เพิ่มเสถียรภาพในการฝึกฝน

7.2 Dropout (2012)

- ป้องกันปัญหา overfitting

- เพิ่มความทนทานของโมเดล

- กลายเป็นเทคนิคมาตรฐานในการฝึกฝนโครงข่ายประสาทเทียม

ผลกระทบต่อโลกปัจจุบัน

การพัฒนาที่ต่อเนื่องของงานวิจัยเหล่านี้ได้นำไปสู่:

- การเกิดขึ้นของ AI assistants ที่สามารถโต้ตอบได้อย่างเป็นธรรมชาติ

- ระบบแปลภาษาที่มีประสิทธิภาพสูง

- การสร้างภาพและเสียงที่สมจริง

- การประยุกต์ใช้ AI ในอุตสาหกรรมต่างๆ

แนวโน้มในอนาคต

งานวิจัยเหล่านี้ยังคงพัฒนาต่อไป โดยมีแนวโน้มสำคัญ:

- การพัฒนาโมเดลที่ใช้ทรัพยากรน้อยลงแต่มีประสิทธิภาพสูงขึ้น

- การผสมผสานความสามารถหลายด้านเข้าด้วยกัน (Multimodal AI)

- การพัฒนา AI ที่มีความสามารถในการให้เหตุผลที่ดีขึ้น

- การมุ่งเน้นความปลอดภัยและจริยธรรมในการพัฒนา AI

สรุป

งานวิจัยที่กล่าวมาทั้งหมดนี้เป็นเพียงส่วนหนึ่งของพัฒนาการในวงการ AI แต่มีความสำคัญอย่างยิ่งต่อความก้าวหน้าที่เราเห็นในปัจจุบัน การเข้าใจประวัติศาสตร์และพัฒนาการเหล่านี้จะช่วยให้เราเข้าใจทิศทางของเทคโนโลยี AI ในอนาคตได้ดียิ่งขึ้น